Google Indexing API: кому нужен, как настроить, кейсы использования

Для seo-специалистов и веб-мастеров вопрос индексации страниц сайта в Google всегда был очень актуальным. Есть достаточно простой способ ускорить индексацию страниц на Google и сделать это массово, а не постранично! Google Indexing API позволяет очень быстро индексировать новые и переиндексировать старые страницы, улучшая видимость вашего сайта в поиске.

Google Indexing API - это программный интерфейс, который позволяет отправлять запрос на индексацию новых и обновленных URL-адресов напрямую поисковой системе. API ускоряет время, необходимое для того, чтобы новый контент стал доступным для пользователей. Фактически это аналог возможностей Яндекс Вебмастера по переобходу и удалению страниц.

Google API особенно актуален для сайтов с динамическим или часто обновляемым контентом: новостные сайты, интернет-магазины и блоги. Он также может быть полезен для ресурсов, которые имеют большой объем контента и обновляются редко, но важно, чтобы изменения в индексе происходили очень быстро.

Как настроить Google Indexing API: 5 простых шагов

Мы выяснили для чего необходим данный инструмент, настало время его настроить. Процесс настройки состоит из следующих блоков:- создание сервисного аккаунта;

- получение JSON-ключа;

- подключение Indexing API к GSC, установка node.js и отправка URL на индексацию.

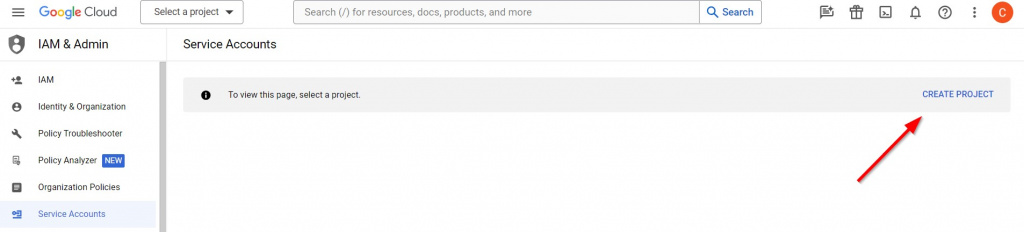

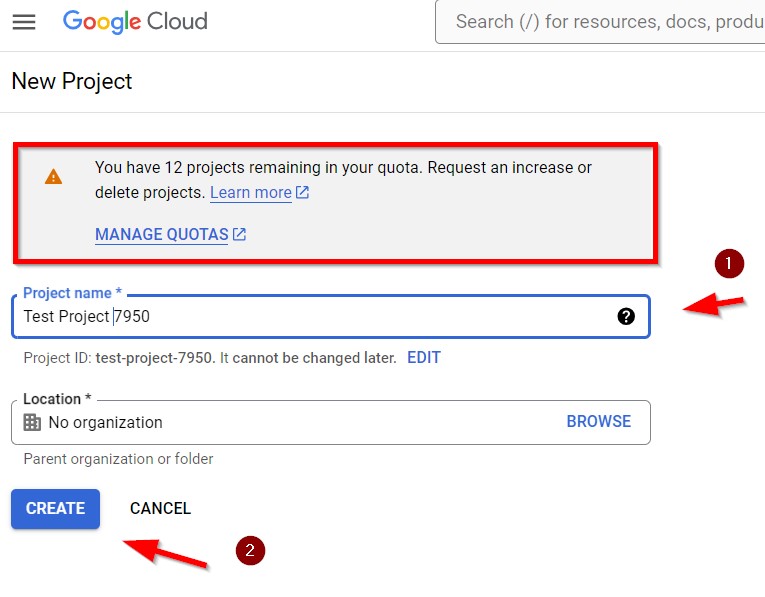

1. Создаем сервисный аккаунт. Переходим на Google Cloud Platform и нажимаем Create Project. Вводим произвольное название проекта.

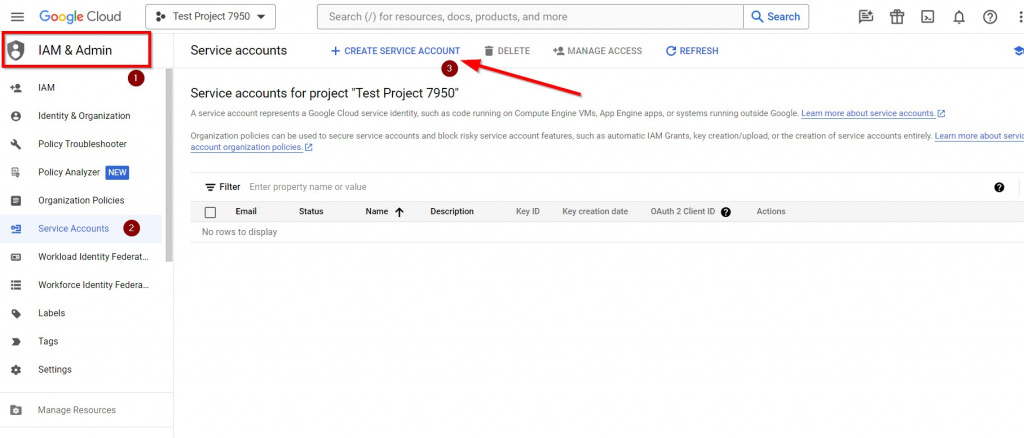

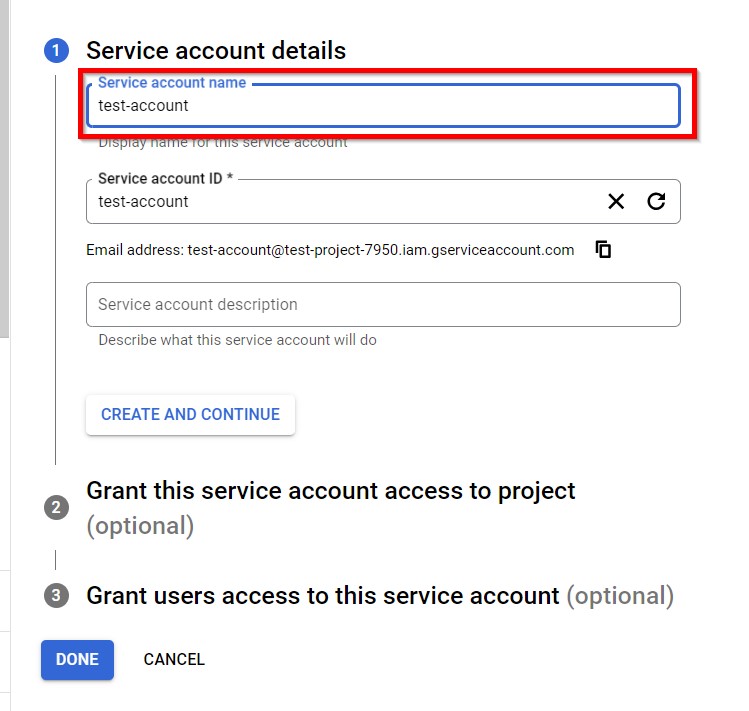

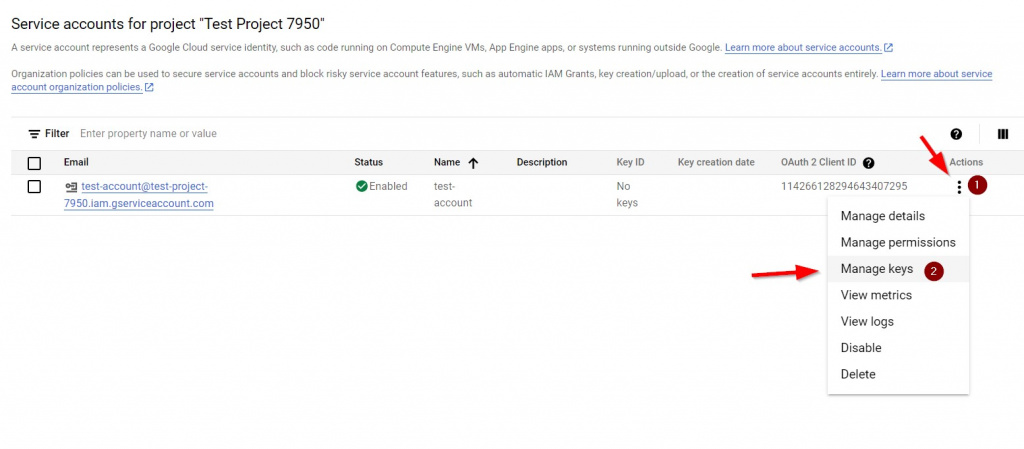

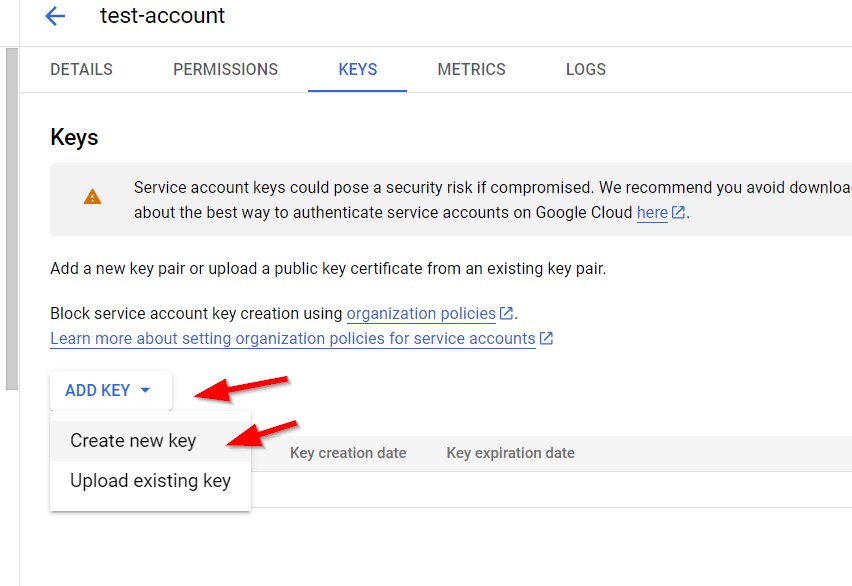

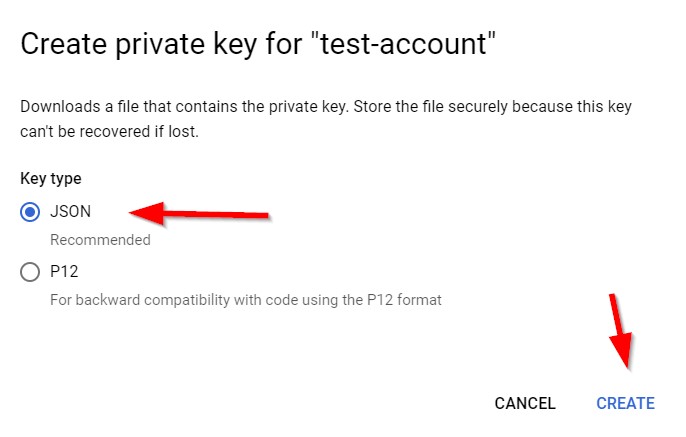

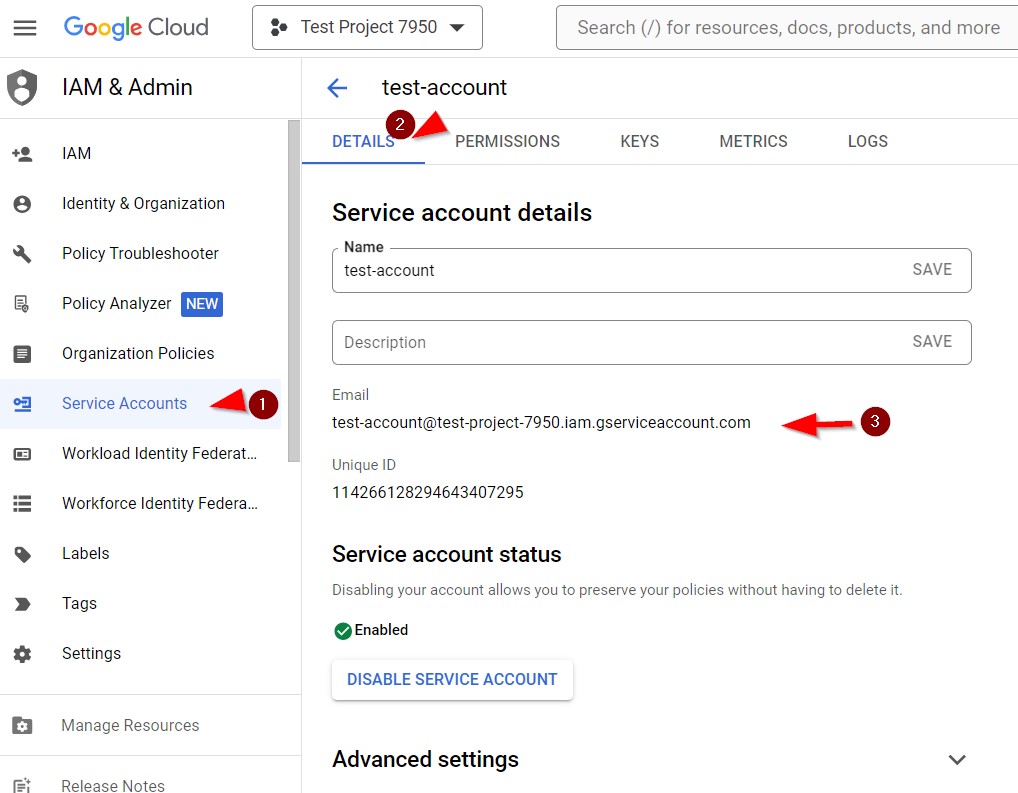

2. Получаем JSON-ключ. Нужно зайти в раздел IAM&ADMIN (сайдбар слева). Там выбираем Service accounts и кликаем на Create service account. Создаем аккаунт, после этого нажимаем на три точки в столбце Actions и выбираем Manage keys, затем Add key -> Create new key. Скачиваем файл с JSON-ключом.

Достаточно ввести имя аккаунта, остальные поля опциональны, заполняйте при необходимости.

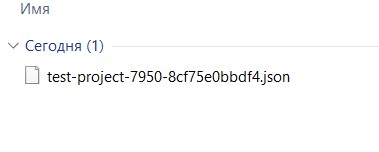

В итоге должен загрузиться ключ.

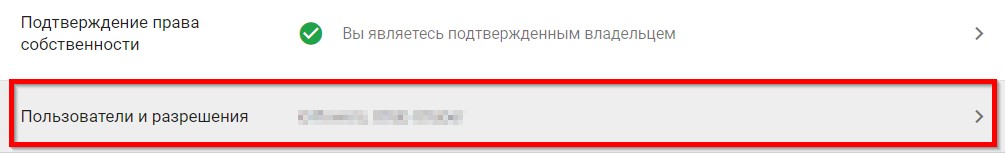

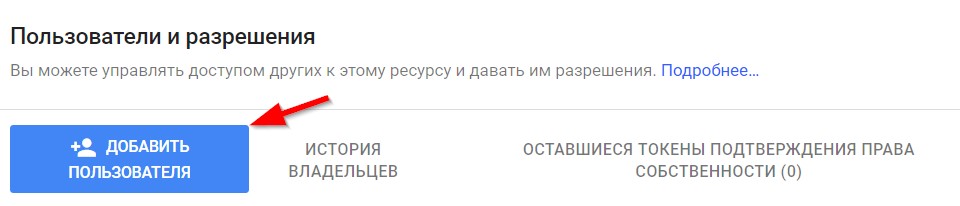

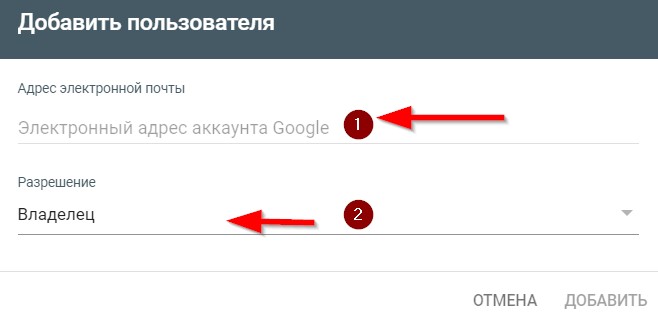

3. Связываем Indexig API и Google Search Console. В GSC заходим в Настройки -> Пользователи и разрешения, жмем «Добавить пользователя». Берем e-mail сервисного аккаунта и предоставляем доступ владельца, для этого после добавления кликаем настройки (три точки), выбираем «изменить разрешение» и ставим статус (разрешение) «владелец», т.к. полного доступа будет недостаточно.

E-mail сервисного аккаунта можно скопировать в Cloud Google Console. В Service Account в табе «Details».

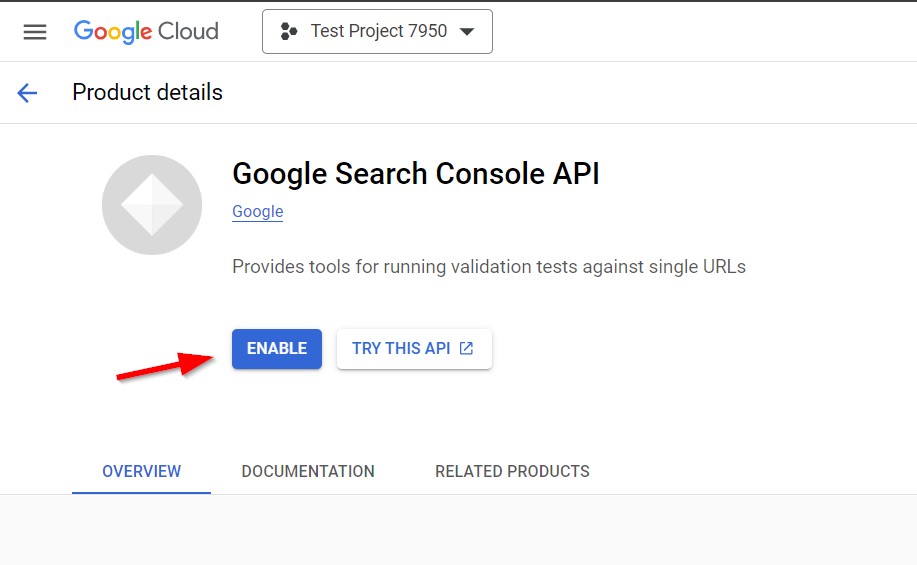

Далее переходим в GCP и включаем Indexing API через кнопку Enable.

4. Устанавливаем node.js. Качаем под свою OS тут и устанавливаем.

Затем скачиваем скрипт массовой отправки URL через node.js с GitHub.

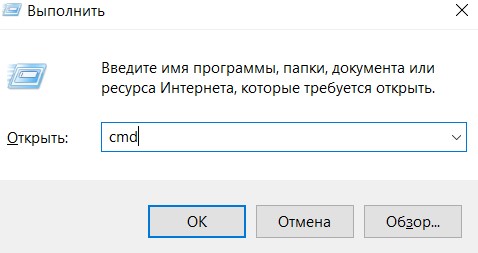

Далее нужно открыть командную строку или терминал (Win+R в открывшейся строке ввести команду cmd).

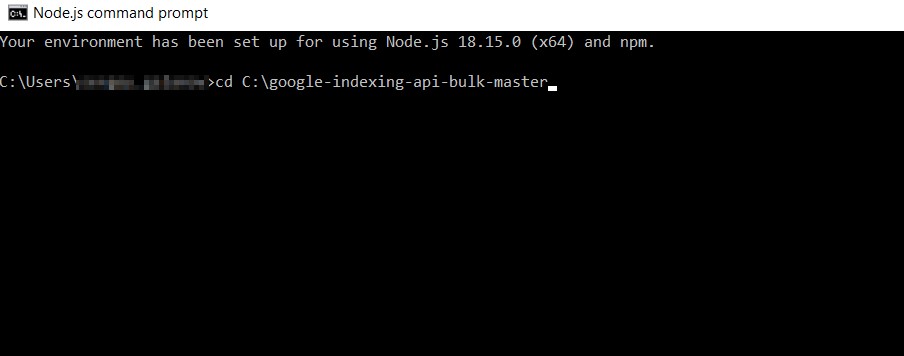

Перейти в папку со скриптом (команда: cd *полный путь до папки*).

Там необходимо выполнить 3 команды: npm install requests, npm audit fix, npm audit fix --force.

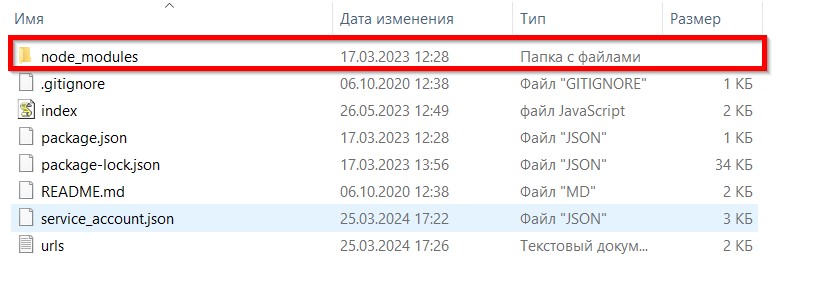

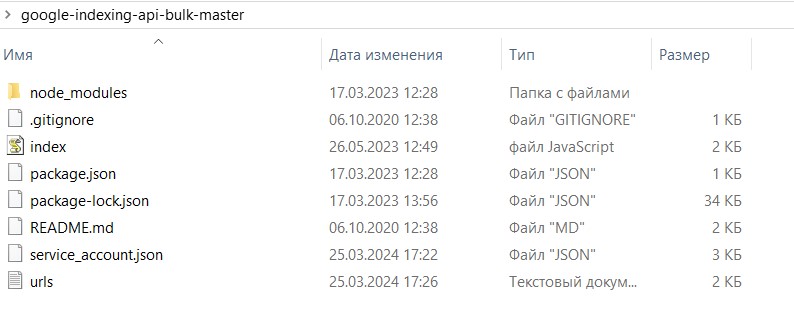

После успешного выполнения в папке со скриптом появится папка «node_modules».

5. Отправляем URLs через Google Indexing API. Заходим в папку со скриптом, открываем файл «service_account.json» и копируем в него содержимое JSON-ключа из пункта выше.

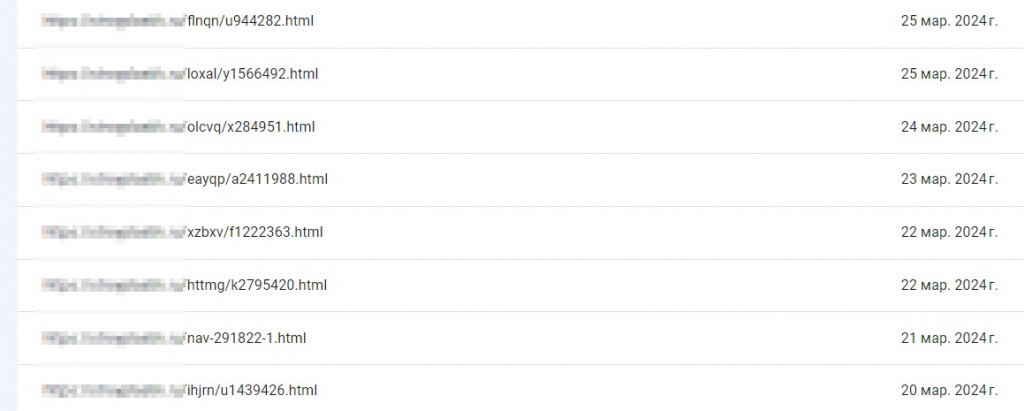

В файл «urls.txt» добавляем адреса страниц, которые хотим проиндексировать. Далее нужно открыть терминал, перейти в папку со скриптом (команда cd *полный путь до папки*) и выполнить команду: node index.js.

Отправлять URL на индексацию также можно через плагины для CMS. Их существует довольно много, для всех распространенных движков. Для этого все равно придется создать сервисный аккаунт и получить JSON-ключ.

Квота в Google составляет 200 URL в сутки и 100 URL за одну выгрузку. Также, как и в IndexNow, данный метод не гарантирует 100% индексации в эту же секунду. Мы всего лишь ставим самый высокий приоритет индексации для Googlebot, а дальше он действует на свое усмотрение.

Описанный алгоритм достаточен для всех типовых ситуаций. Однако, не исключены проблемы индивидуального характера. Если у вас возникли такие нюансы, можно воспользоваться ссылками: Как правильно настроить Console Cloud Google для индексации страниц через API и настройка Search Console и скрипта для индексации страниц в API Google.А зачем мне это нужно? Нюансы индексации веб-страниц в Google

Как было сказано ранее, API облегчает процесс обновления индекса вашего сайта в поисковой выдаче, уменьшая время, необходимое для того, чтобы новый контент стал доступным для пользователей.

Разумеется, у вас может быть готовый список страниц, например, на сайт добавили категорию с товарами и хочется, чтобы они попали в индекс как можно быстрее, но такое встречается не часто.

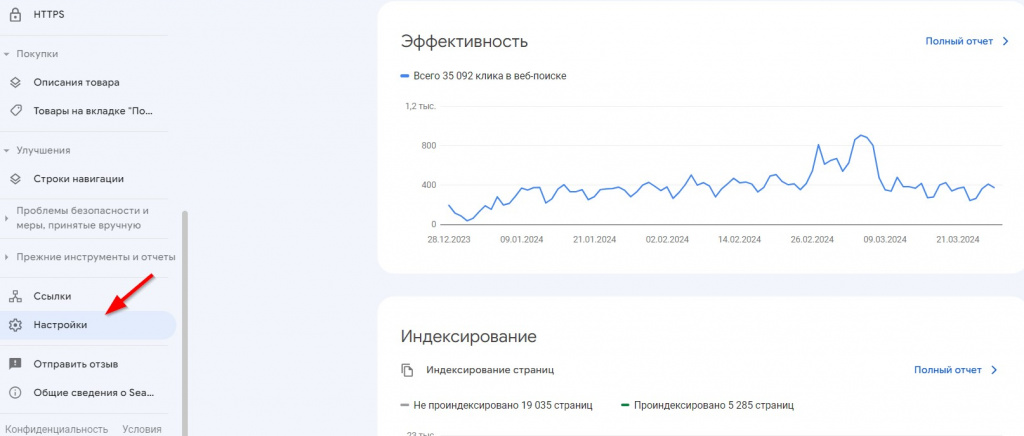

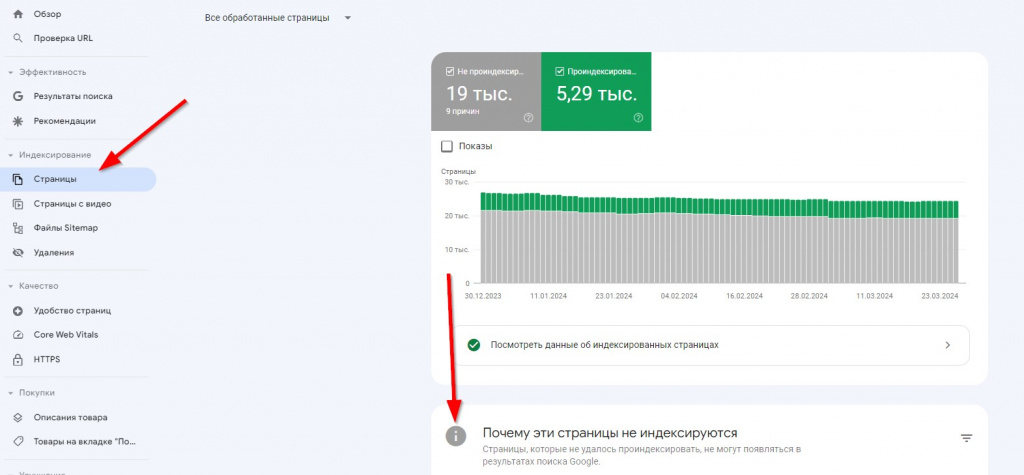

Чтобы понять, какие страницы необходимо отправить на «принудительное» индексирование необходимо вернуться в GSС в раздел «Индексирование» - «Страницы» и посмотреть статусы, которые отображены в отчете (блок «Почему эти страницы не индексируются» под графиком).

1) В основном, необходимо получить страницы со статусами:

- Страница просканирована, но пока не проиндексирована

- Обнаружена, не проиндексирована

Данные статусы условно можно считать аналогом ММС Яндекса (Малоценные или маловостребованные страницы – подробнее можно почитать тут). В зарубежном интернете такие страницы принято называть зомби-страницами.

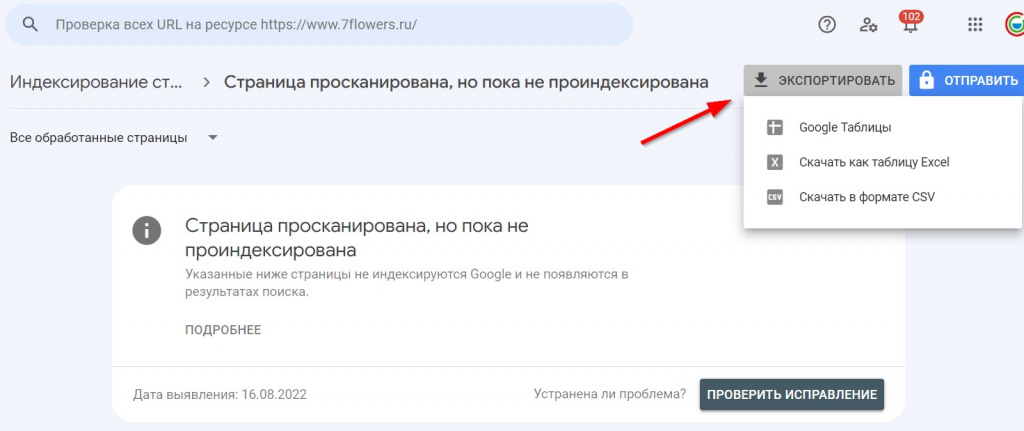

При переходе к списку страниц вы можете их выгрузить различными способами для удобства взаимодействия.

Важно отметить, что перед отправкой всего списка страниц рекомендуется его проверить, ведь не просто так Google выдал страницам подобный статус.

Проверить нужно следующие моменты:

Технический. Страницы отдают 200 код ответа, являются каноническими, не закрыты от индексации?Логический. А нужны ли эти страницы в поиске? Не являются ли они дубликатами или устаревшими документами?

Качественный. В связи с очередными апдейтами Google марта 2024 года стоит оценить страницы по «полезности» для конечного пользователя. Возможно стоит провести определенные работы перед тем, как просить робота прийти на страницу ещё раз.

2) Остальные статусы игнорировать не нужно. Например, следует посмотреть следующие списки:

- Не найдено (404)

- Ошибка сервера (5xx)

- Страница является копией. Канонический вариант не выбран пользователем.

- Заблокировано в файле robots.txt

Статус «Страница является копией. Канонический вариант не выбран пользователем» говорит о том, что на сайте есть неточные/неполные дубли страниц (это частичное копирование информации на страницах с разными адресами). Так же данный статус может указывать на изменившиеся канонический адрес страницы, либо возможное заражение сайта (множество почти одинаковых страниц по странным адресам).

Список страниц со статусом «Заблокировано в файле robots.txt» помогает быстро оценить корректность файла Robots.txt Возможно вы запрещаете доступ к важным страницам, или наоборот, в списке нет непродвигаемых технических страниц.

Проверка статусов, корректировки и переиндексация помогут вам добиться желаемого результата. Некоторые примеры:

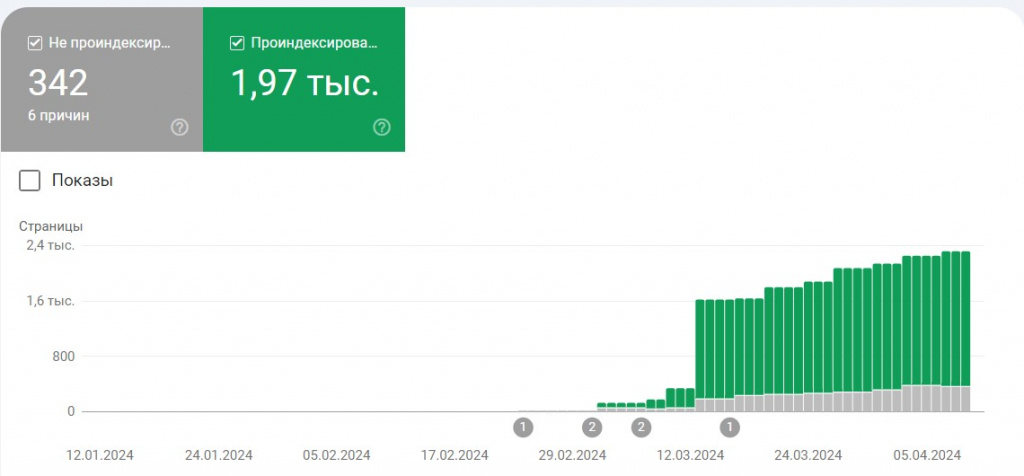

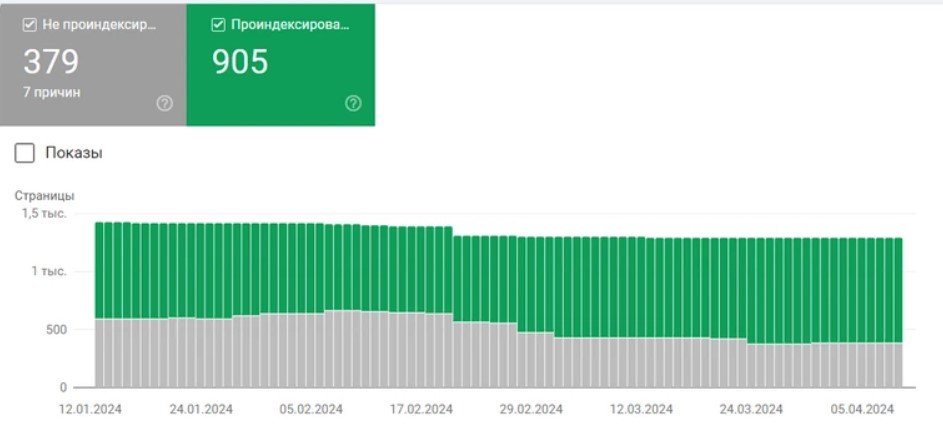

· Рост представления молодого сайта в индексе.

· Улучшение соотношения страниц «в индексе/не в индексе». Стоит отметить, сокращение «серых» столбцов после проработки проблемных страниц (статусов).

Удаление страниц из индекса с помощью Google Indexing API

Небольшой лайфхак. Node.js может не только отправлять страницы на переобход, но просить удалить их из индекса. Делается это относительно просто. Необходимо зайти в папку со скриптом.Открыть файл «index» любым удобным блокнотом (на скриншоте ниже — «notepad++»). Найти строку type: 'URL_UPDATED' и заменить URL_UPDATED на URL_DELETED.

В каких случаях может пригодиться данный функционал. Приведем 3 примера:

- При изменении URL адресов. Возможно вы захотели настроить ЧПУ адреса, настроили 301 редирект со старых и отправили страницы через API. В этот момент робот приходит на страницы, добавляет их в индекс и видит, что точно такие же страницы уже есть, но по другому адресу. Есть вероятность, что страницы по новым адресам будет расценены как «копии» до того момента, пока робот не пройдет по старому адресу и не увидит код ответа отличный от 200.

-

У сайта много неиндексируемых страниц по разным причинам. Например, сайт был заражен вирусом, вы оперативно все починили, но в списке страниц появилась огромное количество 404. Получается ситуация, когда Google знает о 1000 страницах сайта, а полезных страниц в индексе всего 20 (предположим у вас небольшой сайт-визитка). Соотношение странное (для ПС, возможно, тоже), но с помощью API его можно исправить.

Это только гипотеза, если вы ей воспользуетесь, пожалуйста, расскажите о своих результатах order@utlab.ru :)

- Вы удаляете какой-то раздел с товарами. Тут все очевидно – после удаления можно дополнительно сообщить ПС Google о том, что некоторые страницы следует убрать из индекса.

Так же при удалении страниц (которых точно не будет на сайте в последствии), попросите разработчика настроить код ответа 410 Gone, а не стандартный 404 Not Found. 410 код показывает, что страница удалена безвозвратно, и возвращаться за уточнением статуса через какое-то время на неё не стоит, в отличие от 404!

Поздравляем! Теперь у вас есть очень полезный скилл – управление индексом Google! Располагая мощным инструментом для оптимизации видимости вашего веб-контента в поисковой выдаче, вы откроете широкие возможности для повышения эффективности SEO-стратегии. Удачи в проектах!